ЯК ВАС ДУРИТЬ ШТУЧНИЙ ІНТЕЛЕКТ

СЦЕНАРІЙ №1: ВИ ВІДДАЄТЕ ГРОШІ, БО ЧУЄТЕ ЗНАЙОМИЙ ГОЛОС

СЦЕНАРІЙ №1: ВИ ВІДДАЄТЕ ГРОШІ, БО ЧУЄТЕ ЗНАЙОМИЙ ГОЛОС Квітень 2025, Київ. Жінка отримала голосове повідомлення від знайомого через Telegram. Просив терміново позичити гроші — мовляв, форс-мажор, усе пояснить пізніше. Вона не вагаючись переказала потрібну суму.

Згодом з’ясувалося: Telegram її знайомого було зламано, голосове повідомлення виявилося аудіо-діпфейком, згенерованим на основі зразків його голосу з попередніх голосових повідомлень у месенджері.

Ця шахрайська схема працює так:

1. Шахраї отримують несанкціонований доступ до облікового запису (найчастіше — Telegram).

2. Використовуючи попередні голосові повідомлення, збережені у месенджері жертви, та інструменти штучного інтелекту, створюють аудіо-діпфейк — клон її голосу.

3. Далі надсилають фальшиві голосові повідомлення з проханням про грошову допомогу контактам жертви.

5 фактів від McAfee, які змушують насторожитися:

- 45% опитаних відповіли б на діпфейк-повідомлення «від знайомого», не перевіряючи його справжність.

- Лише 27% здатні визначити, чи голос у дзвінку є справжнім, чи згенерованим за допомогою штучного інтелекту.

- 40% погодилися б допомогти фейковому "колезі", почувши знайомий голос.

- 10% респондентів отримували дзвінки з клонованим голосом — 77% з них втратили гроші.

- 3 секунди аудіо — достатньо, щоб створити голос, схожий на ваш.

Як розпізнати аудіо-діпфейк?

- Повідомлення надходить у незвичний час — пізно ввечері або вночі. Мета — застати зненацька.

- Голос звучить неприродньо. Він може бути надто монотонним або трохи роботизованим, із неправильними наголосами чи дивними паузами. Часто використовуються короткі фрази — їх легше згенерувати, а слухач рідше помічає підробку.

- Невластиві вислови чи манера мовлення. Якщо “знайомий” раптом спілкується не так, як зазвичай — це привід засумніватися.

- Відмова відповідати на уточнюючі запитання. Шахраї уникають діалогу, зосереджуючись лише на “терміновості ситуації”, аби тиснути емоційно та спонукати до дії без перевірки.

Що робити, якщо вам пише або надсилає голосове повідомлення знайома людина з проханням позичити гроші?

- Зв’яжіться з нею іншим каналом зв’язку — телефоном, через інший месенджер або особисто. Уточніть, чи справді вона зверталася до вас.

- Задайте перевірочне запитання, відповідь на яке знає лише ця людина. Це може бути особистий факт, спільний спогад або деталь, яка не відома стороннім і не згадується у вашому листуванні в месенджері.

- Ніколи не надсилайте гроші лише через “знайомий голос”. Голоси легко підробити, акаунти — зламати.

Пильність — найкращий захист. Сьогодні достатньо лише 3-х секунд голосу, щоб створити небезпечну ілюзію довіри.

Це лише перший сценарій. Попереду — інші, ще хитріші.

СЦЕНАРІЙ №3: ВИ ЛАЙКАЄТЕ, ПІДПИСУЄТЕСЬ І МОЛИТЕСЯ ЗА ТИХ, КОГО НІКОЛИ НЕ ІСНУВАЛО

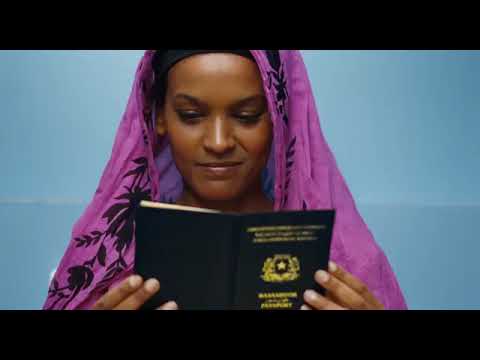

СЦЕНАРІЙ №3: ВИ ЛАЙКАЄТЕ, ПІДПИСУЄТЕСЬ І МОЛИТЕСЯ ЗА ТИХ, КОГО НІКОЛИ НЕ ІСНУВАЛОЗворушливі обличчя.

Трагічні історії.

І збір лайків, емоцій та... довіри.

Насправді — це ще один шахрайський сценарій із використанням нейромереж та штучно згенерованих обличь. Усе починається з щемливого зображення та історії: про бабусю з прифронтової зони, бідних сиріт, загиблого воїна чи загубленого цуценя. Ви лайкаєте. Ви підписуєтесь. Ви довіряєте. А за кілька днів контент на сторінці змінюється — і ви вже читаєте про «зраду», ІПСО та "отримання 9000 гривень допомоги від держави" — що, насправді, виявляється черговою шахрайською пасткою.

Але штучний інтелект любить пожартувати.

На зображеннях у пості та першому коментарі — обличчя людей, яких ніколи не існувало. Це згенеровані нейромережею персонажі, вмонтовані у зворушливі історії, які закликають ставити вподобайки, ділитися дописом та «молитися за героїв».

Та придивіться уважніше:

• Хлопчики в зимовому одязі — їдять молоду картоплю.

• Швабра в руках бабусі-прибиральниці у зеленому — з розряду фантасмагорії.

• Рік народження загиблого воїна на надгробку — 1899.

Це не просто помилки. Це — цифрові артефакти, за якими часто можна розпізнати діпфейк.

Як ще можна розпізнати фейкові обличчя:

• Неприродня міміка, «застиглий» або емоційно плаский вираз обличчя

• Асиметрія рис обличчя та аксесуарів: очі різного розміру або кольору, одне вухо, одна сережка, дивна усмішка

• Неправильні тіні, візуальні викривлення фону, ненатуральні або надто яскраві кольори

• Фото виглядає як “на документи” — чітке обличчя на розмитому фоні

Resemble AI

Створює та розпізнає діпфейки у відео, аудіо та зображеннях. Перші спроби — безкоштовні.

DeepFake-O-Meter

Онлайн-детектор фейків від Університету Буффало. Перевіряє відео, аудіо й фото. Потрібна попередня реєстрація.

AI or Not

Визначає, чи створено зображення, відео чи аудіо, за допомогою ШІ. Перевірка за URL або файлом. 10 запитів щомісяця — безкоштовно.

Sensity AI

Професійна платформа для виявлення діпфейків. Доступний безкоштовний пробний доступ після реєстрації.

Deepware Scanner

Аналізує відео на ознаки діпфейку. Веб-версія — безкоштовна для персонального користування.

Attestiv

Інструмент для перевірки відео й фото на підробку. Потрібна реєстрація, базовий функціонал — безкоштовний.

Image Verification Assistant

Професійний інструмент для судової експертизи зображень: аналіз метаданих і виявлення цифрових викривлень.

Порада: не покладайтеся лише на автоматичні інструменти або власні очі. Поєднуйте автоматичні детектори з ручною перевіркою зображень — це підвищує точність виявлення діпфейків.

І наступного разу, коли захочети поставити вподобайку публікації на кшталт «Вам не соромно сподобатися ця картинка» або «Сьогодні мій день народження, і поруч нікого не має. Цікаво, скільки людей мене привітає» — зробіть паузу. Придивіться уважніше. Запитайте себе: чи все в зображенні та дописі виглядає логічно, природньо, реалістично?

Це вже третій сценарій шахрайства з використанням штучного інтелекту. Перші два — про “знайомі голоси” та “знайомі обличчя” — шукайте у нашій стрічці.

Будьте в курсі — і на крок попереду шахраїв.

Школа Кібербезпеки